1、聚焦爬蟲工作(zuò)原理(lǐ)及關鍵技(jì)術(shù)概述

網絡爬蟲是一個(gè)自動提取網頁的程序,它為(wèi)搜索引擎從Internet網上(shàng)下載網頁,是搜索引擎的重要組成。傳統爬蟲從一個(gè)或若幹初始網頁的URL開(kāi)始,獲得(de)初始網頁上(shàng)的URL,在抓取網頁的過程中,不斷從當前頁面上(shàng)抽取新的URL放入隊列,直到滿足系統的一定停止條件。聚焦爬蟲的工作(zuò)流程較為(wèi)複雜,需要根據一定的網頁分析算(suàn)法過濾與主題無關的鏈接,保留有(yǒu)用的鏈接并将其放入等待抓取的URL隊列。然後,它将根據一定的搜索策略從隊列中選擇下一步要抓取的網頁URL,并重複上(shàng)述過程,直到達到系統的某一條件時(shí)停止,另外,所有(yǒu)被爬蟲抓取的網頁将會(huì)被系統存貯,進行(xíng)一定的分析、過濾,并建立索引,以便之後的查詢和(hé)檢索;對于聚焦爬蟲來(lái)說,這一過程所得(de)到的分析結果還(hái)可(kě)能對以後的抓取過程給出反饋和(hé)指導。

相對于通(tōng)用網絡爬蟲,聚焦爬蟲還(hái)需要解決三個(gè)主要問題:

對抓取目标的描述或定義;

對網頁或數(shù)據的分析與過濾;

對URL的搜索策略。

抓取目标的描述和(hé)定義是決定網頁分析算(suàn)法與URL搜索策略如何制(zhì)訂的基礎。而網頁分析算(suàn)法和(hé)候選URL排序算(suàn)法是決定搜索引擎所提供的服務形式和(hé)爬蟲網頁抓取行(xíng)為(wèi)的關鍵所在。這兩個(gè)部分的算(suàn)法又是緊密相關的。

猜你(nǐ)喜歡

- 1同城預售次日送小(xiǎo)程序

- 2協同辦公在線文檔系統軟件開(kāi)發

- 3百度關鍵詞推廣-提高(gāo)曝光吸引精準用戶才是硬道(dào)理(lǐ)

- 4線上(shàng)營銷線下消費小(xiǎo)程序開(kāi)啓流量争奪戰

- 5智能快遞櫃APP開(kāi)發功能

- 6app軟件開(kāi)發團隊應該是有(yǒu)哪幾個(gè)團隊組成

- 7校(xiào)園教務的小(xiǎo)程序

- 8制(zhì)造業網站(zhàn)和(hé)APP軟件功能開(kāi)發

- 9什麽樣的網站(zhàn)設計(jì)更有(yǒu)利于網站(zhàn)推廣

- 10會(huì)員管理(lǐ)系統定制(zhì)軟件開(kāi)發

聯絡方式:

電(diàn)話(huà):150 3833 0582

郵箱:278477169@qq.com

-

app軟件開(kāi)發公司有(yǒu)哪些(xiē)

鄭州地區(qū)做(zuò)APP軟件的公司什麽類型的都有(yǒu),主要是看客戶想開(kāi)發哪些(xiē)類型的,具體(tǐ)小(xiǎo)公司還(hái)是大(dà)公司看開(kāi)發的app屬于什麽難度。小(xiǎo)公司的開(kāi)發實力也不亞于大(dà)公司,在性價比上(shàng)也是類...

-

教育小(xiǎo)程序開(kāi)發

移動互聯網的到來(lái),經過小(xiǎo)程序的出現,得(de)到大(dà)批的流量,因為(wèi)小(xiǎo)程序的用戶多(duō),教育小(xiǎo)程序也會(huì)成為(wèi)以後的市場(chǎng),所以相關的教育培訓企業也會(huì)将也會(huì)開(kāi)發相關的教育小(xiǎo)程序軟件。 ...

-

智能家(jiā)電(diàn)APP軟件定制(zhì)開(kāi)發

定制(zhì)型智能家(jiā)電(diàn)APP開(kāi)發介紹 現在的社會(huì)科技(jì)氛圍越來(lái)越濃了,機器(qì)替代人(rén)工作(zuò)的行(xíng)業已經逐漸呈現出來(lái),在智能家(jiā)居上(shàng)所有(yǒu)的工作(zuò)都是由機器(qì)完成的話(huà)那(nà)肯定會(huì)是一個(gè)繁瑣的事...

-

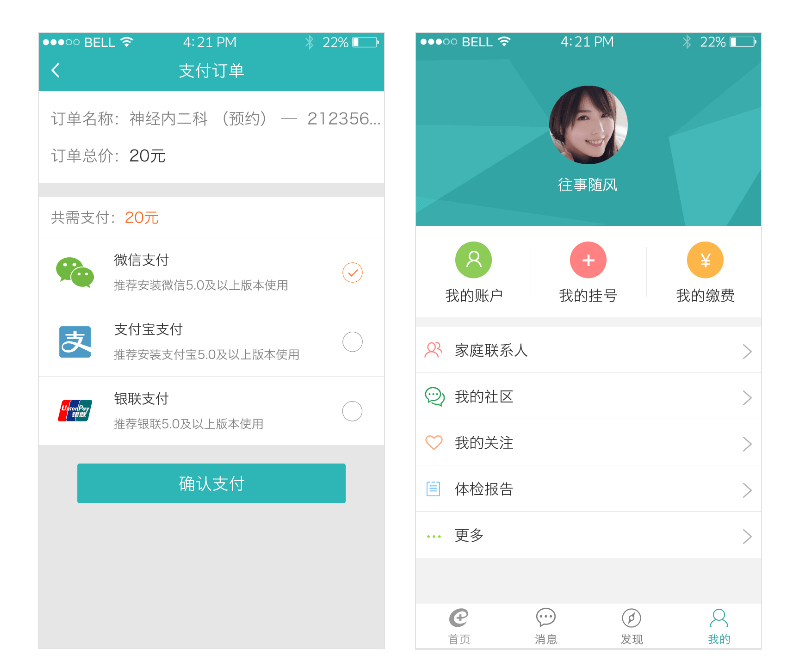

醫(yī)療APP軟件開(kāi)發解決方案

一、醫(yī)療衛生(shēng)APP概述 醫(yī)療APP軟件是基于安卓和(hé)iso開(kāi)發的移動端軟件。它的發展對國內(nèi)的醫(yī)療服務提供了有(yǒu)效的解決方法,在醫(yī)療人(rén)力資源短(duǎn)缺的情況下,通(tōng)過移動醫(yī)療解決方...

-

綜合金融貸款APP開(kāi)發

金融APP開(kāi)發概述 金融方面的APP軟件開(kāi)發方向比較多(duō),理(lǐ)财和(hé)股票(piào)的居多(duō),還(hái)有(yǒu)外彙和(hé)基金屬性的,交易所,區(qū)塊鏈的都是一些(xiē)提供消費的理(lǐ)财服務,通(tōng)過數(shù)據得(de)出數(shù)據化的分析和(hé)運...